Es sollte klar sein das eine 1050Ti sehr sehr schwach für ein KI-System ist, aber es geht grade noch so!

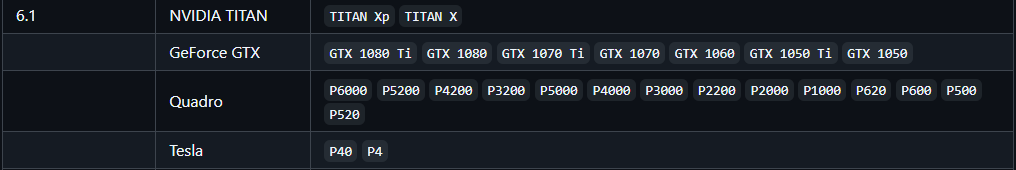

Hier findet man eine Aufzählung was noch an GFK Unterstützt wird: ollama/ollamablob/main/docs/gpu.md

Meine 1050Ti ist noch dabei 👍️

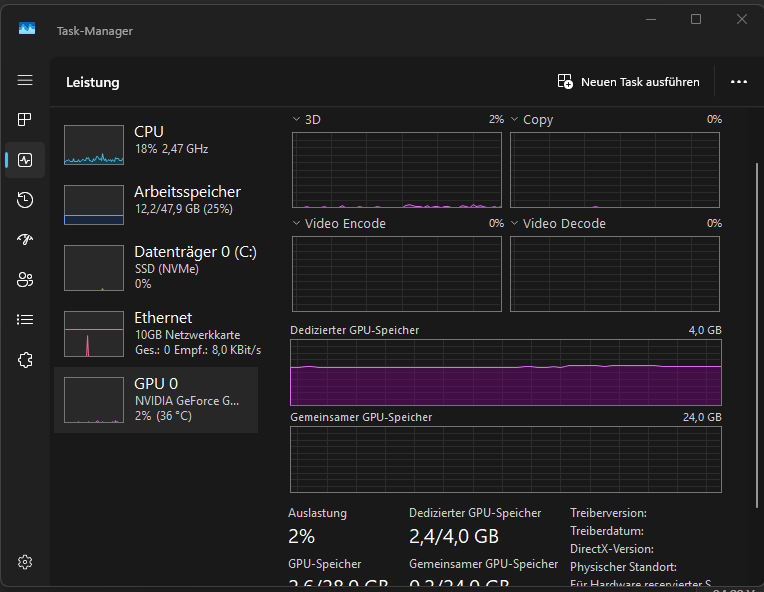

Bei mir läuft das, zum Testen, auf meinem Windows 11 Desktop PC mit einer Intel i7-9700 CPU und 48GB Nutzbaren Arbeitsspeicher.

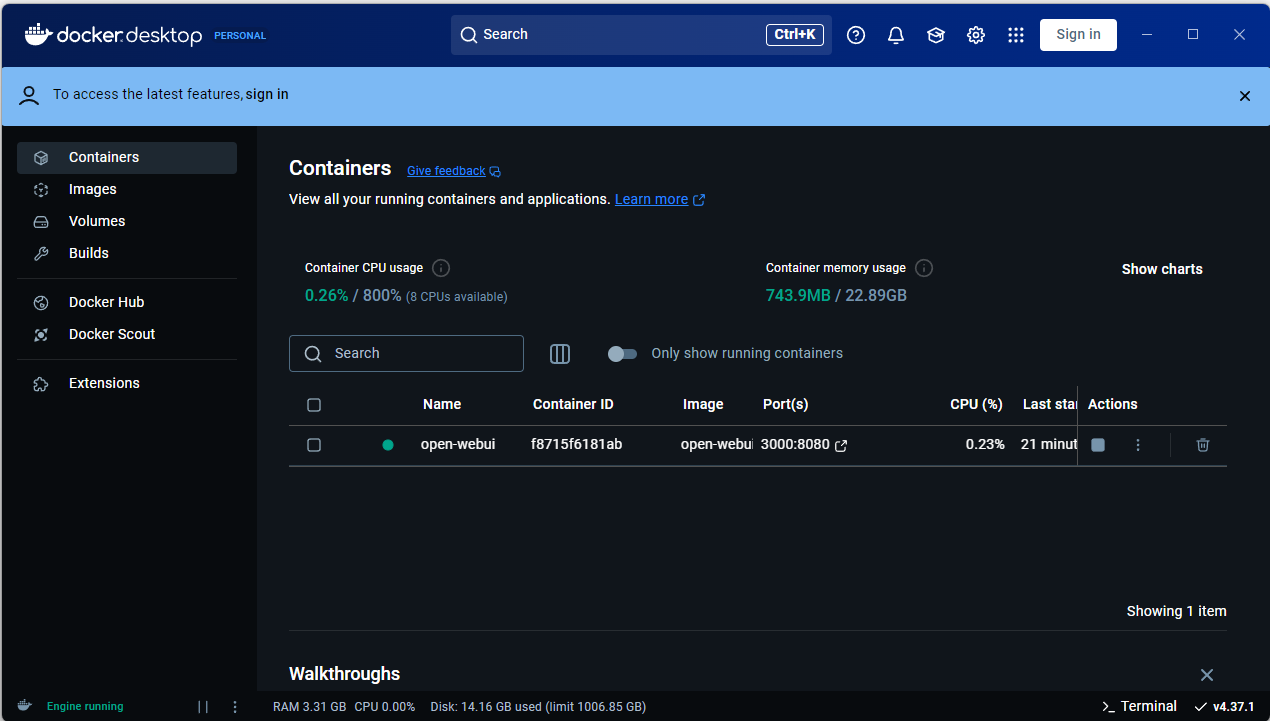

Dann solltet Ihr sicherstellen das Ihr Docker Installieren könnt, ein kleines Tool um Grafisch Angezeigt zu bekommen was Ihr an Docker Installiert habt wäre “Docker Desktop”, das bekommt Ihr hier: https://www.docker.com/products/docker-desktop/

P.S. ich habe die komplette Anmeldung übersprungen, also kein Name, keine eMail angegeben 👍️

Jetzt installieren wir OpenWeb GUI, inkl. Ollama 3 und Cuda - open-webui/open-webui

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

Nach der Installation müsst Ihr nur die Ip eures PCs + :3000 angeben, also z.B. 192.168.178.22:3000

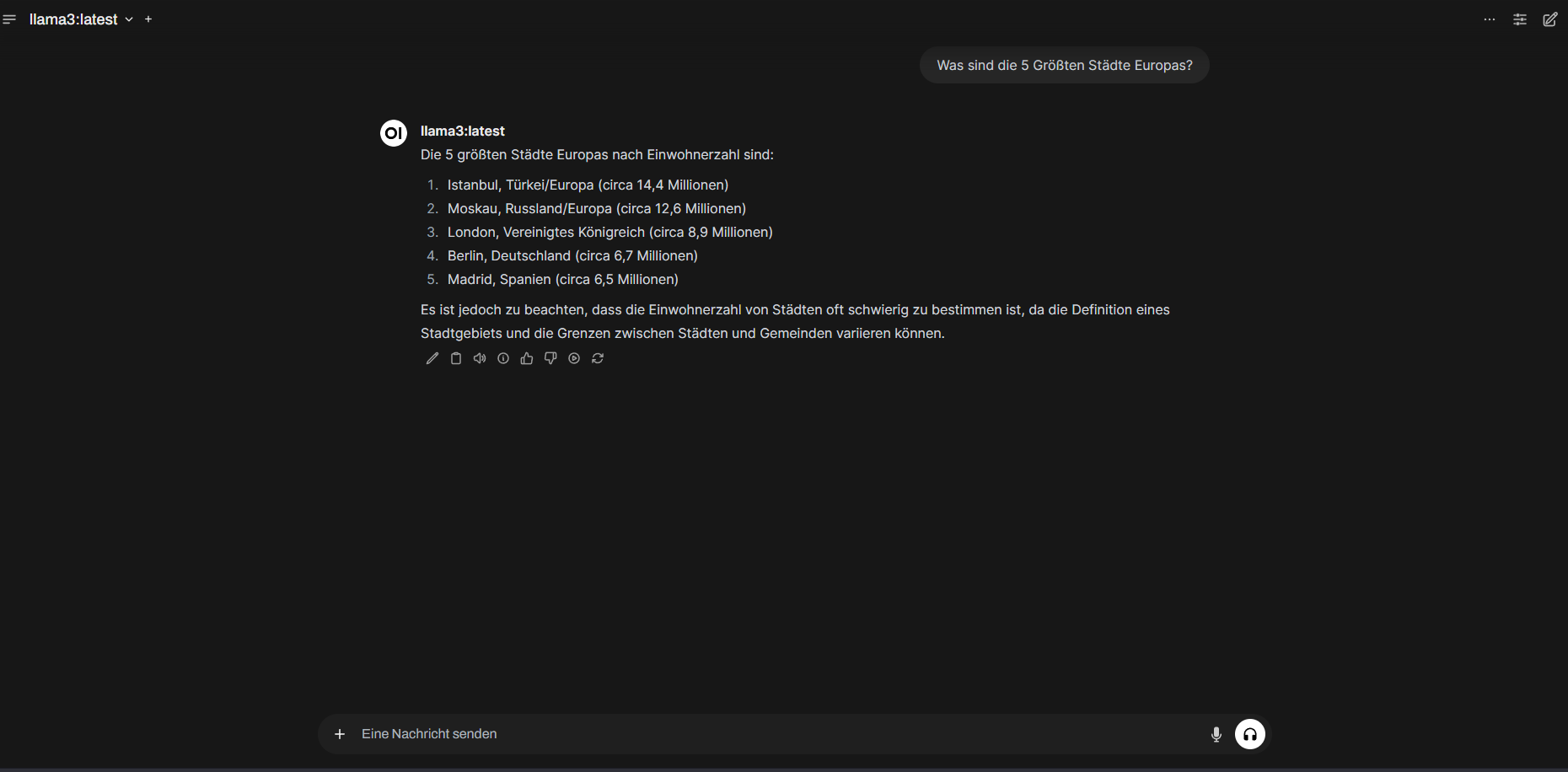

Jetzt Erstellt ein Adminkonto und los geht es mit der KI Nutzung

Das war eine Einfache Frage, für die Antwort benötigte das Systen 28 Sekunden!

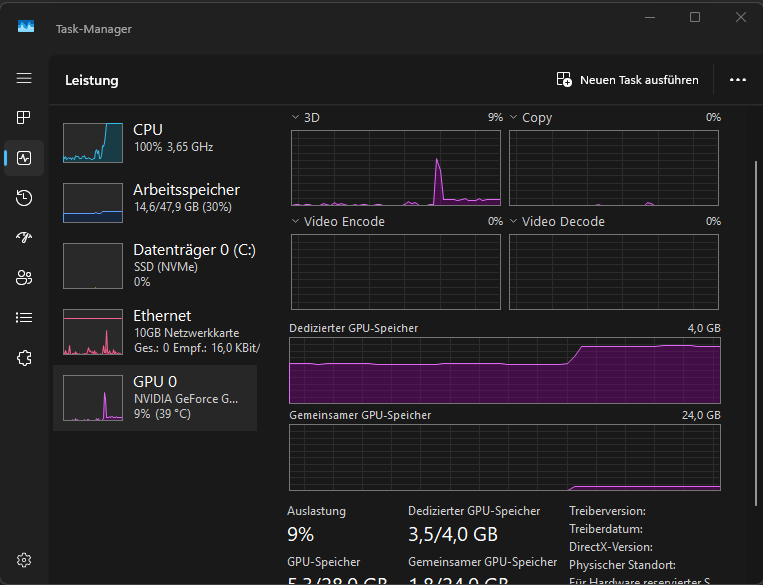

Wobei vom “Dedizierten 4GB Grafikspeicher” 2GB Verwendet wurden und 1,8GB vom Gemeinsamen GPU-Speicher.

Das System vor der Anfrage

Das System wärend der Anfrage, GPU Last steigt nur auf 9%, aber die CPU steigt auf 100% an, sowie o.g. der GPU-Ram wird mit 2GB ausgenutzt sowie 1,8GB gemeinsamer GPU-Speicher.

Wenn es Probleme mit Cuda gibt oder Ihr das System selbst Tainieren wollt dann schaut euch mal das Nvidia Cuda Toolkit an.

https://developer.nvidia.com/cuda-downloads